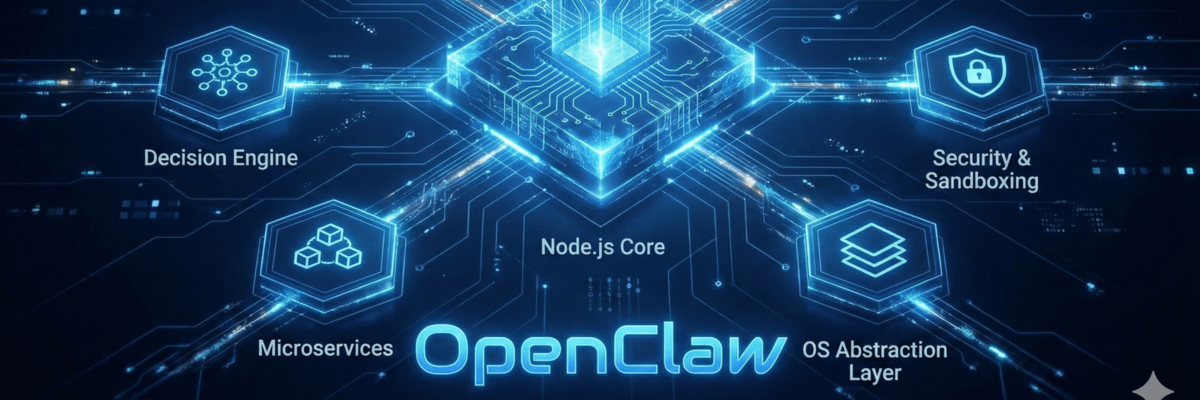

1. Die Architektur des "Agentic OS" (Node.js Core)

Technisch gesehen basiert OpenClaw auf einer Event-gesteuerten Microservice-Architektur innerhalb einer Node.js-Instanz.

- Der Orchestrator (State Machine): OpenClaw nutzt keine einfache lineare Abfrage. Es implementiert einen sogenannten ReAct-Loop (Reasoning + Acting). Wenn eine Nachricht eingeht, wird diese in einen Thought-Prozess überführt. Der Orchestrator verwaltet einen Zustandsautomaten (State Machine), der entscheidet, ob das LLM weitere Informationen benötigt (Observation) oder ein Tool aufrufen muss (Action).

- Modell-Agnostik via Unified API: Intern nutzt OpenClaw oft Bibliotheken wie Vercel AI SDK oder LangChain, um eine Abstraktionsschicht über verschiedene LLM-Provider zu legen. Technisch bedeutet das: Die Payload für einen Prompt wird standardisiert. Ob dahinter ein gpt-4o, claude-3-5-sonnet oder ein lokales Llama 3 via Ollama liegt, ist dem Core egal. Er transformiert die spezifischen API-Antworten in ein einheitliches internes JSON-Format.

- Messaging-Bridge (Webhook-Architektur): Die Anbindung an WhatsApp/Telegram erfolgt meist über Headless-Browser-Automatisierung (wie whatsapp-web.js) oder offizielle Webhooks. Der Clou: Der Messenger dient als Standard-Input/Output (STDIN/STDOUT). Eingehende Nachrichten werden als Events emittiert, vom Agenten verarbeitet und die Antwort als asynchroner Callback an den Messenger-Service zurückgegeben.

2. Der Execution Layer & MCP (Model Context Protocol)

Dies ist der technisch komplexeste Teil. OpenClaw nutzt das von Anthropic eingeführte MCP.

- MCP-Clients & Server: OpenClaw fungiert als MCP-Client. Er kann sich mit beliebig vielen lokalen oder entfernten MCP-Servern verbinden. Ein MCP-Server ist ein separater Prozess, der eine standardisierte JSON-RPC-Schnittstelle bietet.

- Tool-Injektion: Beim Senden des Prompts an das LLM "injiziert" OpenClaw die Definitionen aller verfügbaren Tools (z.B. read_file, execute_shell, Google Search) in den System-Prompt. Das LLM antwortet nicht mit Text, sondern mit einem strukturierten Tool-Call (z.B. { "call": "execute_shell", "command": "ls -la" }).

- Sandboxing vs. Native Execution: Während Cloud-KIs in Docker-Containern laufen, führt OpenClaw (je nach Konfiguration) Befehle oft nativ in der Shell des Host-Systems aus. Technisch wird dies über die Node.js child_process-Library realisiert. Das erlaubt volle Kontrolle über das OS, erfordert aber Sicherheitsmechanismen wie "Human-in-the-loop"-Bestätigungen für kritische Commands.

3. Persistenter Speicher: Die Markdown-Vektordatenbank-Hybrid-Logik

Warum Markdown (SOUL.md, MEMORY.md) statt einer SQL-Datenbank?

- Context Window Management: LLMs haben ein begrenztes Kontextfenster. OpenClaw nutzt eine Technik namens RAG (Retrieval-Augmented Generation), aber auf Dateiebene.

- Technischer Ablauf: Bevor ein Prompt gesendet wird, liest ein Skript die Markdown-Dateien. Wichtige Passagen werden oft mittels Embeddings (Vektorisierung des Textes) in einen temporären Vektor-Index geladen. Nur die für die aktuelle Aufgabe relevanten "Schnipsel" aus der MEMORY.md werden in den Prompt kopiert.

- Self-Updating Files: Nach Abschluss einer Aufgabe generiert der Agent eine Zusammenfassung. Ein Tool-Call schreibt diese aktiv zurück in die Markdown-Datei. Technisch ist das ein fs.writeFile-Vorgang, der durch das LLM gesteuert wird, um den eigenen "Zustand" für die nächste Sitzung zu serialisieren.

4. Proaktive Kommunikation (The Heartbeat Mechanism)

Technisch gesehen ist ein klassischer Chatbot ein Request-Response-System (wie HTTP). OpenClaw bricht dies auf:

- Cron-Jobs & Event-Loop: OpenClaw setzt im Hintergrund Node-Cron-Jobs oder setTimeout-Instanzen.

- Autonome Trigger: Ein Agent kann sich selbst einen "Wake-up-Call" setzen. Beispiel: "Prüfe in 2 Stunden, ob die Aktie X gefallen ist." Technisch registriert der Agent einen Task in einer internen Queue. Sobald der Timer abläuft, wird ein neuer Thought-Loop initiiert – ganz ohne User-Input. Das Ergebnis wird dann asynchron über die Messaging-Bridge an den User gepusht.

5. Vibe Coding & Local-First

- Vibe Coding (Technisch): Das bedeutet, dass der Code von OpenClaw oft so modular aufgebaut ist, dass KI-Editoren (wie Cursor oder Windsurf) Funktionen extrem schnell erweitern können. Die Architektur setzt auf Funktionale Programmierung und klare Interfaces, was es der KI erlaubt, sich selbst "Heilungs-Skripte" zu schreiben oder neue Tools zur Laufzeit zu generieren.

- Local-First: Die Latenz ist minimal, da keine schweren Backend-Server dazwischengeschaltet sind. Die Datenhoheit liegt beim Nutzer, da der node_modules-Ordner und die .md-Files physisch auf der Festplatte liegen.

Zusammenfassend:

OpenClaw ist technisch gesehen ein lokaler Laufzeit-Knoten, der LLM-Intelligenz via JSON-RPC (MCP) mit dem Betriebssystem verdrahtet und über asynchrone Messaging-Events steuerbar macht.